Sie sind ein Experte auf Ihrem Gebiet. Ein Experte bis ins Mark. Während Ihrer langjährigen Erfahrung in der Versicherungsbranche haben Sie umfangreiche Kenntnisse gesammelt und beraten nicht nur gerne Ihre Kunden – in der Regel solide Unternehmen –, sondern stehen auch Ihren jüngeren Kolleginnen und Kollegen mit Rat und Tat zur Seite. Stellen Sie sich vor, genau das ist der Fall, und ein junger, aber fleißiger Kollege wendet sich mit der Bitte an Sie, ihm bei der Planung einer digitalen Dokumentenverarbeitungskette zu helfen. Was würden Sie ihm raten?

Fühlten Sie sich angesprochen?

Das, was Sie gerade gelesen haben, war nicht an Sie gerichtet, obwohl sich viele von Ihnen durchaus in solch einer Situation wiederfinden könnten. Tatsächlich ist der Adressat des oben genannten Textes ein großes KI-Sprachmodell. Der Text selbst ist ein sogenannter Prompt, und die Kunst, ihn zu schreiben, wird als Prompting (Prompt Engineering) bezeichnet.

In den letzten Monaten sind Gespräche über ChatGPT, einen Chatbot, der auf einem dieser großen Sprachmodelle basiert, an niemandem vorbeigegangen. Aber das ist bei Weitem nicht das einzige große Sprachmodell: Jeder IT-Riese hat entweder sein eigenes Sprachmodell bereits veröffentlicht oder zumindest angekündigt. Aber was genau bedeutet das Aufkommen von großen Sprach- und bald auch multimodalen Modellen für die Versicherungsbranche? Welche Rolle spielt die Größe eines Sprachmodells?

Betrachtet man das Angebot an Tools zur automatisierten Analyse von natürlicher Sprache, so stellt man fest, dass beinahe täglich neue Innovationen auf den Markt drängen, die in ihrer Performanz noch vor wenigen Jahren undenkbar erschienen. Technisch steckt meist eine API-Schnittstelle zu einem der GPT-Modelle hinter den Anwendungen, welches mittels Prompts angesprochen wird und den gewünschten Output liefert. Auch aus der Versicherungsbranche gibt es erste Beispiele. So stellt die Helvetia ihren Kunden einen Chatbot zur Verfügung, der basierend auf der ChatGPT-Technologie Kundenanfragen in Echtzeit beantwortet.

Wie OpenAI GPT-Modelle trainiert

Um zu evaluieren, auf welche Bereiche das Modell anwendbar ist, lohnt es sich, einen Blick darauf zu werfen, wie OpenAI die GPT-Modelle trainiert. GPT steht für „generative pretrained transformer“. Zum Training werden riesige Textkorpora genutzt. Diese werden dem Modell im Trainingsprozess allerdings maskiert präsentiert, d.h. es werden einzelne Wörter geschwärzt. Das Modell lernt so, Wörter aus ihrem Kontext vorherzusagen, und kann Wortketten sehr gut wahrscheinlichkeitsbasiert vervollständigen – oder eben auf einem Prompt aufbauend Texte als Antwort generieren.

Genau hier liegt die Stärke des Modells: Es kann erstaunliche Resultate auf allerlei kreative Aufgaben der Sprachverarbeitung leisten – und das, ohne Anforderungen an die Schnittstelle zum Endnutzer zu stellen. Es drängt sich die Frage auf, ob ChatGPT die Zukunft der Sprachverarbeitung ist. Schließlich lässt es sich mittels Prompt-Engineering flexibel auf nahezu alle Aufgaben anwenden.

Fragt man ChatGPT selbst, so sagt es, dass andere vektorbasierte Sprachmodelle nach wie vor ihre Berechtigung haben, beispielsweise in der Klassifikation von Texten. Aber ist das lediglich die „politisch korrekte“ Antwort, die ChatGPT aufgrund von Filtern gibt, oder entspricht das der Realität?

Was sind vektorbasierte Sprachmodelle?

Vektorbasierte Wortmodelle lernen Wortrepräsentationen – ähnlich wie die GPT-Modelle aus Textkorpora numerische Repräsentationen von Wörtern. Diese Repräsentationen sind allerdings nach dem Trainingsprozess fixiert, es wird bei der Anwendung nicht auf Prompts reagiert (Granularität). Dies macht die Modelle weniger spektakulär und kreativ, bietet in der praktischen Anwendung allerdings auch Vorteile:

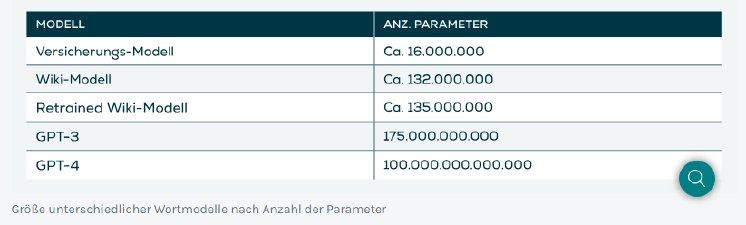

- Die Modelle sind deutlich kleiner (siehe Tabelle 1). Zum Training werden daher weit weniger Daten benötigt, und Modelle können i. d. R. auf einer lokalen Infrastruktur trainiert und gehalten werden.

- Es ergeben sich Vorteile in Kosteneffizienz, Kontrollierbarkeit, Nachvollziehbarkeit, bei der Anpassung an die Domäne, z.B. spartenspezifische Sprache, und in Bezug auf den Datenschutz.

Exemplarisch betrachten wir im Folgenden „fasttext“, eine 2015 von Facebook entwickelte Modellarchitektur.

Im Folgenden schauen wir uns drei mögliche Konfigurationen des fasttext-Modells an:

- Versicherungsmodell: ein Modell, welches ausschließlich auf ca. 5.000 Versicherungsdokumenten, insb. Allgemeinen Versicherungsbedingungen (AVB), trainiert wurde

- Wiki-Modell: von fasttext vortrainiertes Modell, welchem die deutsche Wikipedia zugrunde liegt [https://fasttext.cc/... ]

- Retrained-Modell: Wiki-Modell angereichert („nachtrainiert“) mit den Dokumenten aus dem „Versicherungsmodell“

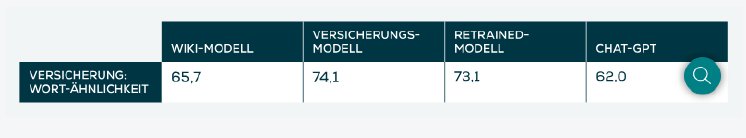

Während ChatGPT und das Wikipedia-Modell nur etwas mehr als die Hälfte der Synonyme erkennen, liefern die spartenspezifischen Modelle eine bessere Performance. Sie lernen die Bedeutungen von fachspezifischen Worten also besser als die allgemeinen Modelle.

Die Evaluation von ChatGPT auf der Grundlage der Versicherungssynonyme ist nicht so trivial wie das Evaluieren der fasttext-Modelle, da ChatGPT als Large Language Model (LLM) keine inhärente Ähnlichkeitsmetrik besitzt und man hier mittels Prompt Engineering eine geeignete Art finden muss, wie das Modell die Resultate in gewünschter Form liefert. Die Fehler, die ChatGPT in unserer Evaluation macht, zeigen das Problem deutlich auf: So antwortet das Modell manchmal in ganzen Sätzen statt mit einzelnen Wörtern oder es liefert Wörter, die im Input nicht zur Auswahl stehen.

Warum sich das Trainieren eigener Sprachmodelle lohnt

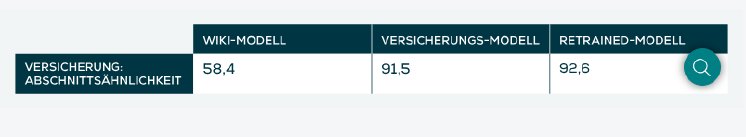

Unsere in der Praxis erprobten KI-Use-Cases unter Verwendung mit Wortmodellen wie fasttext basieren häufig auf dem Identifizieren von semantisch ähnlichen Texten und Abschnitten. Darauf lassen sich vortrainierte Modelle wie das Online-Modell unter Verwendung einiger weniger domänenspezifischer Dokumente anpassen. Auch hier wurde von Versicherungsexperten eine Evaluationsgrundlage geschaffen, welche sich aus der Zuordnung von semantisch ähnlichen Textabschnitten aus Versicherungsbedingungen unterschiedlicher Versicherer speist.

Hier zeigt sich dann zum ersten Mal der tatsächliche Vorteil des Trainierens eigener Wortmodelle: Das Training eines allgemeinen Modells (z. B. auf Wikipedia) liefert keine optimalen Ergebnisse, wenn wir es auf anders strukturierte Daten anwenden. Unsere eigens (nach)trainierten Modelle wurden auf Texten trainiert, die denen sehr ähnlich sind, auf die sie letztendlich angewendet werden, und erzielen daher deutlich bessere Werte. Eine domänenspezifische Anpassung von Modellen – insbesondere bei spezialisierten Aufgaben – ist hier gegenüber allgemeinen Modellen überlegen. Dennoch profitiert das „Retrained Modell“ von der allgemeinen Grundlage, die durch das Vortrainieren auf Wikipedia geschaffen wurde. Sie sind meist robuster. Ein angepasstes, allgemeines Modell, das auf eine spezifische Domäne nachtrainiert wurde, ist daher die ideale Mischung aus Robustheit und Spezialisierung.

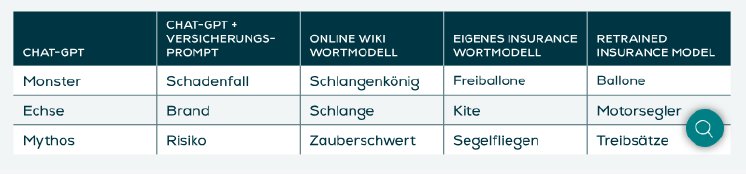

Schließlich lässt sich noch ein interessantes, wenngleich anekdotisches Beispiel aufzeigen: Das „Halluzinieren“ ist ein bekanntes Phänomen beim Verwenden von generativen Sprachmodellen wie ChatGPT. Dabei liefert das Modell fehlerhafte oder inkohärente Antworten:

- weil es zum Beispiel Anweisungen nicht oder falsch „versteht“

- oder einfach fehlerhafte Wortketten generiert.

Wir haben unsere Wortmodelle und auch ChatGPT nach den ähnlichsten Wörtern zum Wort „Drachen“ gefragt und haben folgende Antworten erhalten: (Grafik 4)

Wichtigkeit von Kontext

Der Vergleich der beiden vektorbasierten Sprachmodelle – des auf Versicherungstexten trainierten und des Wikipedia-Modells – zeigt sofort, wie wichtig das Trainingsgebiet und folglich der Kontext für die Bedeutungsextraktion von Wörtern aus dem Korpus sind. Wenn wir uns auf die Darstellung von „Drachen“ in Wikipedia stützen, werden uns Synonyme rund um das Fabelwesen angezeigt. In einem Insurance-Wortmodell und Retrained Insurance-Modell erhält das Wort „Drachen“ die Bedeutung, die wir in Versicherungsdokumenten erwarten würden.

Ähnliches können wir beobachten, wenn wir die Ergebnisse von ChatGPT vor dem Prompting und danach vergleichen. Auch hier ist die erste assoziative Verknüpfung das Fabelwesen. Wenn wir das Modell entsprechend „vorbereiten“ und ihm „erklären“, dass uns ausschließlich der Kontext der Versicherung interessiert, können wir sehen, wie sich die Semantik verändert. Es ist interessant, dass das Wort „Brand“ einerseits zur Assoziation mit einem Drachen in seiner märchenhaften Bedeutung passt, andererseits aber auch im Kontext der Versicherung nicht fremd ist. Bislang ist es nicht möglich, den genauen Ursprung einer bestimmten Assoziation zu bestimmen. Dies stellt die Hauptherausforderung beim Aufbau zuverlässiger Lösungsansätze mithilfe generativer Modelle dar.

Fazit

ChatGPT und andere generative Large Language Models zeigen hochgradig spannende und beeindruckende Resultate auf dem Gebiet der Textgenerierung und bei anderen kreativen Aufgaben. Auch in der Versicherungsbranche ergeben sich daraus zahlreiche Anwendungspotenziale.

Im Kern von zahlreichen Use Cases aus der Versicherungsbranche steht häufig die Herausforderung, Texte vergleichen zu müssen. Aus Sicht der Sprachmodelle lässt sich dies auf das Berechnen von semantischer Ähnlichkeit herunterbrechen. Hierfür sind LLMs im Allgemeinen nicht ausgelegt, und es zeigen sich einige Herausforderungen in der Anwendung dieser Modelle auf so gelagerte Anwendungsbereiche.

Es gilt also keinesfalls „je größer, desto besser“, was Sprachmodelle und deren Einsatz im Versicherungsumfeld angeht. Vielmehr müssen zunächst die Anforderungen und Ziele der Verwendung von KI geprüft werden. Häufig reichen kompaktere Standardmodelle bereits aus – oder die Herausforderung ist ohne ein spartenspezifisch nachtrainiertes Modell unlösbar.