Native FP16 Unterstützung, schnelle Portierung und Bereitstellung neuraler Netzwerke im Caffee oder Tensorflow Format und ein geringer Stromverbrauch sind Hauptmerkmale der MyriadTM X VPU. Durch die Multi-Channel Fähigkeit lässt sich jeder einzelnen VPU eine andere DL-Topologie zuweisen um simultane Berechnungen auszuführen. AlexNet, GoogleNet, Yolo Tiny, SSD300, ResNet, SqueezeNet oder MobileNet sind nur ein kleiner Teil der unterstützen Topologien. Die Kompatibilität mit dem Open Visual Inference Neural Network Optimization (OpenVINO™) Toolkit von Intel® sorgt für eine Performance Optimierung des eingespielten Trainingsmodels und nimmt eine passende Skalierung auf das Zielsystem an der Edge vor. Daraus ergibt sich eine optimierte Integration ohne langwieriges Trail und Error.

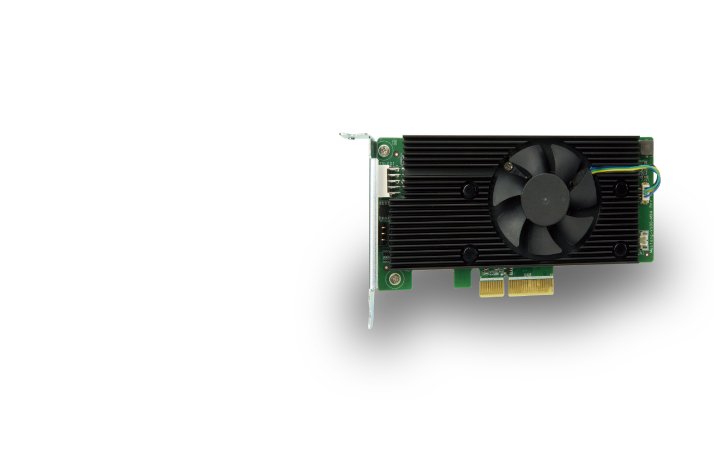

Die Mustang-V100 Serie ist mit einer Vielzahl von gängigen Betriebssystemen wie Ubuntu 16.04, CentosOS 7.4 und Windows 10 IoT kompatibel. Durch den geringen Stromverbrauch von 2,5 Watt pro VPU, beziehungsweise 15 Watt Gesamtverbrauch der Mustang-V100-MX4, eignet sie sich damit besonders für Low-Power KI Anwendungen. Neben der Mustang-V100-MX4 mit 4 VPU Einheiten bietet ICP Deutschland eine PCIe Variante mit 8 VPU Einheiten sowie Varianten die auf dem Mini-PCIe und M.2 Bus basieren.

Produktlink

Datenblatt Mustang AI Accelerator