Bei generativer KI (GenAI) handelt es sich um einen inhärent hybriden Workload. Neue Anwendungen werden oft in der Public Cloud erstellt, während die Modelle auf Basis privater Daten in On-premises-Umgebungen angepasst und feinjustiert werden. Die Inferenzierung findet hingegen in der unmittelbaren Nähe des Betriebsorts der Geschäftslogik statt, ob am Edge, on-premises oder in der Public Cloud. Dieser verteilte hybride GenAI-Workflow kann jedoch für Unternehmen eine Herausforderung hinsichtlich Komplexität, Datenschutz, Sicherheit und Kosten darstellen.

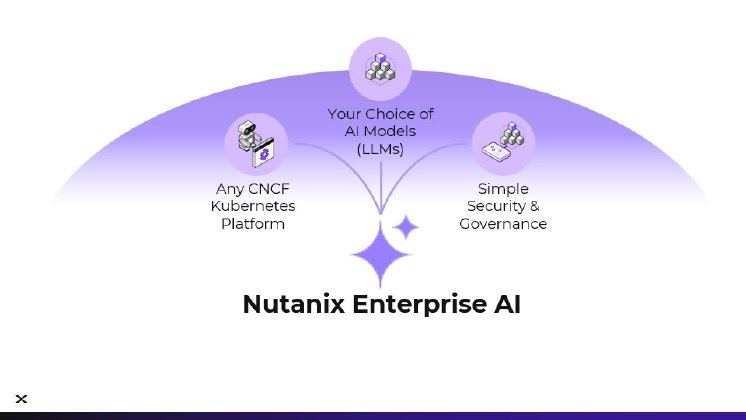

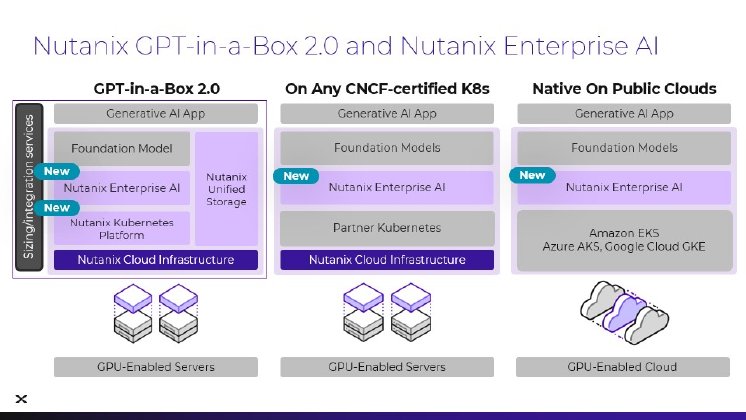

Nutanix Enterprise AI bietet ein konsistentes Multicloud-Betriebsmodell und eine einfache Möglichkeit, LLMs mithilfe der NVIDIA NIM-optimierten Inferencing-Microservices und quelloffener Basismodelle von Hugging Face sicher bereitzustellen, zu skalieren und zu betreiben. Dadurch können Kunden eine Enterprise-GenAI-Infrastruktur mit dem Maß an Resilienz, Betriebsmöglichkeiten und Sicherheit aufbauen, das sie für geschäftskritische Anwendungen benötigen, ob on-premises oder auf AWS Elastic Kubernetes Service (EKS), Azure Managed Kubernetes Service (AKS) und Google Kubernetes Engine (GKE).

Darüber hinaus bietet Nutanix Enterprise AI ein transparentes Preismodell auf der Basis von Infrastrukturressourcen, so dass sich Budgets verlässlich planen lassen. Im Gegensatz zu nutzungs- oder Token-abhängigen Preismodellen, mit denen sich Ausgaben nur schwer vorausberechnen lassen, dürfte das Nutanix-Modell für Kunden von Interesse sein, die mit ihren GenAI-Investitionen eine möglichst hohe Rendite erzielen wollen.

Nutanix Enterprise AI ist eine neue Komponente von GPT-in-a-Box 2.0. Das Angebot beinhaltet die HCI-Software Nutanix Cloud Infrastructure (NCI), die Nutanix-Kubernetes-Plattform NKP sowie die Block-, Objekt- und Dateispeicherlösung Nutanix Unified Storage (NUS). Darüber hinaus enthält GPT-in-a-Box 2.0 Services zur Unterstützung von Kundenanforderungen hinsichtlich Konfiguration und Sizing für On-premises-Training und -Inferencing. Kunden können bei Bedarf Nutanix Enterprise AI in verschiedensten Kubernetes-Umgebungen in der Public Cloud bereitstellen und konsistent zusammen mit On-premises-Bereitstellungen betreiben.

„Mit Nutanix Enterprise AI helfen wir unseren Kunden, GenAI-Anwendungen einfach und sicher on-premises oder in Public-Cloud-Umgebungen zu betreiben. Nutanix Enterprise AI läuft auf verschiedensten Kubernetes-Plattformen und erlaubt Kunden mit seinem berechenbaren Kostenmodell, ihre KI-Anwendungen an einem sicheren Ort auszuführen”, so Thomas Cornely, Senior Vice President, Product Management bei Nutanix.

Nutanix Enterprise AI lässt sich zusammen mit der Full-Stack-KI-Plattform von NVIDIA bereitstellen und ist für die Softwareplattform NVIDIA AI Enterprise validiert, einschließlich NVIDIA NIM: Die einfach zu nutzenden Inferencing-Microservices sind dafür konzipiert, hochperformantes KI-Modell-Inferencing sicher und zuverlässig bereitzustellen. Die leistungsstarke GPT-in-a-Box-Lösung ist von NVIDIA zertifiziert.

„Generative KI-Workloads sind inhärent hybrid; Training, individuelle Anpassungen und Inferencing finden in Public-Cloud-Umgebungen, On-premises-Systemen und am Edge statt”, erklärt Justin Boitano, Vice President, Enterprise AI bei NVIDIA. „Durch die Integration von NVIDIA NIM in Nutanix Enterprise AI entsteht ein konsistentes Multicloud-Modell mit sicheren APIs. Kunden können dadurch KI in verschiedensten Umgebungen mit dem für geschäftskritische Anwendungen erforderlichen Grad an Leistung und Sicherheit bereitstellen.”

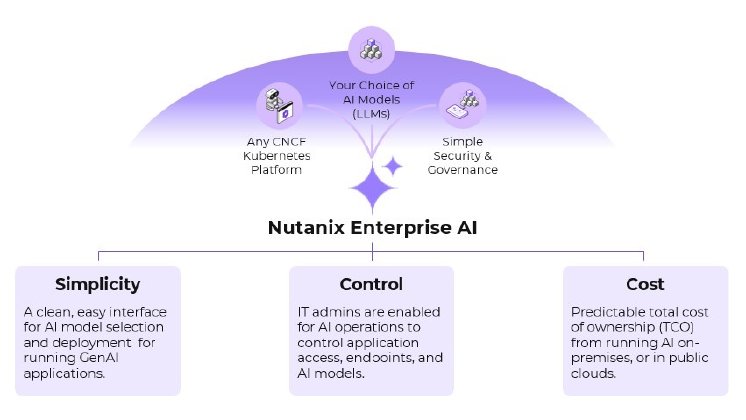

Nutanix Enterprise AI kann Kunden helfen,

- fehlende KI-Kompetenzen auszugleichen. Einfachheit, Wahlfreiheit und die mitgelieferten NAI-Features machen IT-Administratoren zu KI-Managern. Datenwissenschaftler können die KI-Entwicklung beschleunigen, während Entwickler die neuesten Modelle mithilfe der beschleunigten NVIDIA-Verarbeitung nutzen und anpassen können.

- Hürden beim Aufbau einer KI-fähigen Plattform zu beseitigen. Viele Unternehmen wollen GenAI einführen, haben aber mit dem Aufbau der geeigneten Plattform zu kämpfen, um KI-Workloads zu unterstützen und für Konsistenz in ihren On-premises-Infrastrukturen und unterschiedlichen Public-Cloud-Umgebungen zu sorgen. Mithilfe von Nutanix Enterprise AI und dessen einfach zu bedienenden und benutzerfreundlichen Workflows lassen sich diese Aufgaben meistern und können Kunden Endpunkte für LLM-Inferencing innerhalb von Minuten bereitstellen und testen. Dadurch und durch den Support für die umgebungsunabhängigen NVIDIA NIM-Microservices erhalten Kunden Wahlfreiheit und können für die optimale Leistung ihrer Modelle sowohl on-premises als auch in Cloud-Umgebungen sorgen. NAI unterstützt Hugging Face und weitere Modellstandards. Darüber hinaus gibt die native Integration mit der Nutanix Kubernetes Platform Kunden die Möglichkeit, sämtliche Angebote der Nutanix Cloud Platform oder aber verschiedenste andere Kubernetes-Laufzeitumgebungen wie AWS EKS, Azure AKS und Google Cloud GKE zusammen mit den NVIDIA-Lösungen für beschleunigtes Computing zu nutzen.

- Datenschutz- und Sicherheitsbedenken auszuräumen. Nutanix Enterprise AI versetzt Kunden in die Lage, Modelle und Daten auf Rechenressourcen zu betreiben, die sie kontrollieren und steuern. Dies hilft ihnen, Datenschutz- und Sicherheitsrisiken zu beseitigen. Darüber hinaus enthält NAI ein intuitiv bedienbares Dashboard zu Fehlerermittlung und -beseitigung, Observability und Kontrolle des Ressourcenverbrauchs bei der Nutzung von LLMs. Zusätzlich bietet die Lösung schnell und sicher einsetzbare rollenabhängige Zugriffskontrollen (RBAC), um für einen kontrollierten und transparenten LLM-Zugriff zu sorgen. Unternehmen, die höchste Sicherheitsstandards voraussetzen, können NAI auch in isolierten (air-gapped) oder Darksite-Umgebungen bereitstellen.

- GenAI-Workloads mit Enterprise-Infrastrukturen auszustatten. Kunden, die bereits die Nutanix Cloud Platform für geschäftskritische Anwendungen einsetzen, können nun auch ihre GenAI-Workloads mit demselben Maß an Resilienz, Day2-Betriebsprozessen und Sicherheit ausstatten und für eine Infrastrukturerfahrung auf Enterprise-Niveau sorgen.

Nutanix Enterprise AI für den Einsatz on-premises, am Edge oder in der Public Cloud und Nutanix GPT-in-a-Box 2.0 sind für Kunden ab sofort erhältlich. Weitere Informationen finden sich unter Nutanix.com/enterprise-ai.

Zitate:

- „Durch die enge Zusammenarbeit zwischen Nutanix und Hugging Face sind Kunden von Nutanix Enterprise AI in der Lage, die beliebtesten offenen Modelle auf einem einfach zu nutzenden und vollständig getesteten Stack bereitzustellen – jetzt auch in Public-Cloud-Umgebungen”, betont Jeff Boudier, Head of Product bei Hugging Face.

- „Nutanix Enterprise AI bietet eine konsistente Anwendererfahrung vom Unternehmen bis in die Public Cloud. Das Angebot zielt darauf ab, eine benutzerfreundliche Infrastrukturplattform bereitzustellen, die Unternehmen auf jeder Etappe ihrer KI-Reise unterstützt, von der Public Cloud bis zum Edge”, erklärt Dave Pearson, Infrastructure Research VP bei IDC.