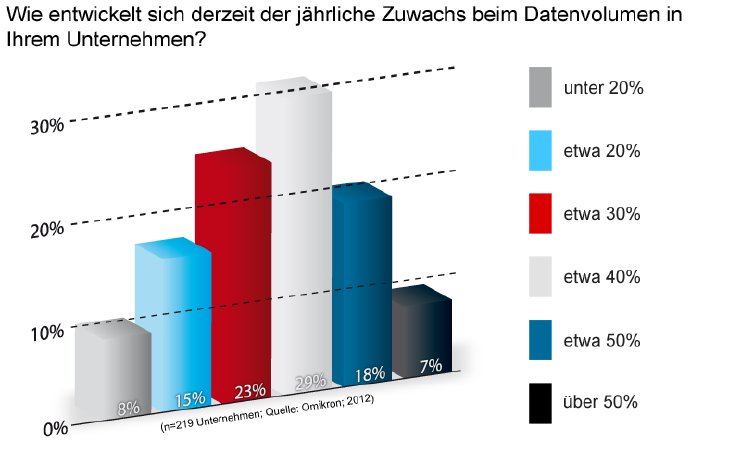

Der Erhebung zufolge stehen die Unternehmen in den nächsten Jahren vor einem sich gewaltig entwickelnden Datenvolumen. In jedem vierten Fall beträgt derzeit das jährliche Wachstum 50 Prozent und mehr. Umgekehrt liegt der Anteil der Firmen, die eine vergleichsweise geringe Volumenentwicklung von einem Fünftel und weniger pro Jahr haben, lediglich bei 23 Prozent.

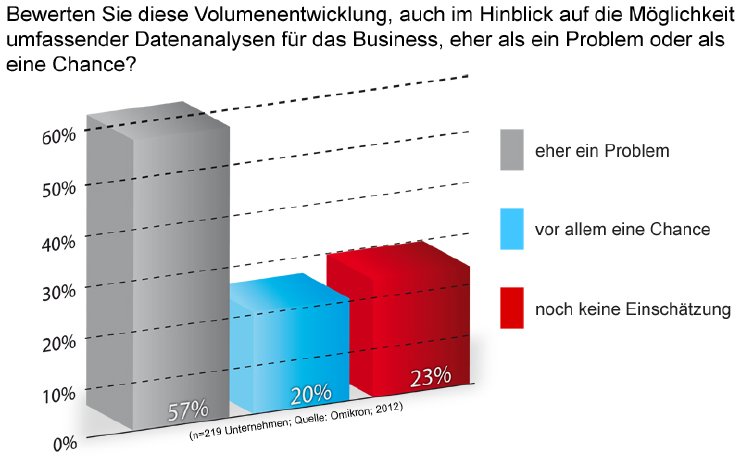

Doch obwohl die Zunahme der Informationsmenge grundsätzlich auch neue Optionen für Datenanalysen bietet, stehen die Unternehmen diesen Möglichkeiten noch recht skeptisch gegenüber. Nur 20 Prozent bewerten die Volumenentwicklung in der Hinsicht primär als Chance, für eine deutliche Mehrheit von 57 Prozent verbirgt sich dahinter jedoch in erster Linie ein Problem.

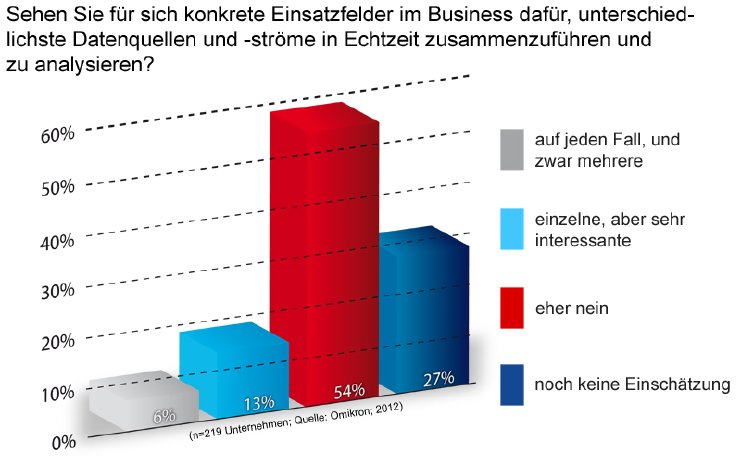

Diese Haltung kristallisiert sich auch bei der Frage heraus, ob die befragten IT-Verantwortlichen für eine Zusammenführung und Analyse unterschiedlichsten Datenquellen schon konkrete Business-Einsatzfelder identifiziert haben. Dies gilt erst für jeden Fünften, während 54 Prozent derzeit noch keinerlei Anwendungsmöglichkeiten für Big Data erkennen. Interessant ist der mit 29 Prozent vergleichsweise hohe Anteil derjenigen, die sich dazu noch gar nicht positioniert haben, weil ihnen offenbar der Zugang zu diesem Thema fehlt.

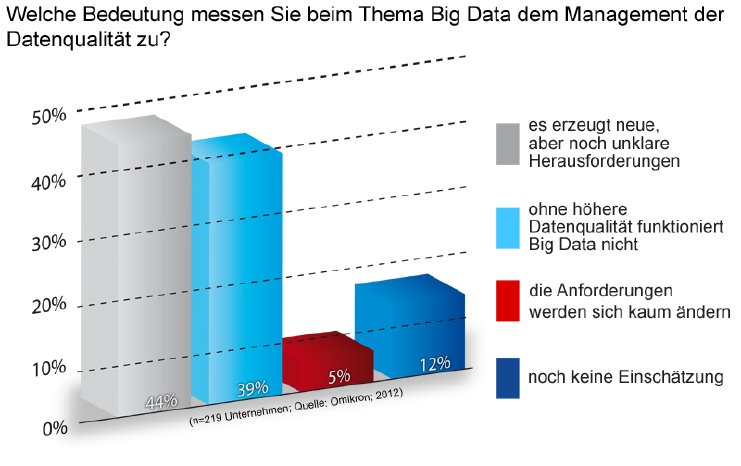

Allerdings besteht in Sachen Datenqualität bei den Befragten eine relativ große Überstimmung. Hier ist der Anteil der IT-Verantwortlichen, die noch über keine ausreichende Einschätzung verfügen, nicht nur deutlich geringer. Sondern der überwiegende Teil misst mit Blick auf Big Data der Datenqualität eine enorme Bedeutung zu. So urteilen 44 Prozent, dass daraus neue, aber noch nicht ausreichend klare Herausforderungen erwachsen. Weitere 39 Prozent werden sogar noch deutlicher und äußern die Meinung, ohne eine höhere Datenqualität seien Big Data-Ansätze zum Scheitern verurteilt.

Diese Auffassung vertritt auch Carsten Kraus, Geschäftsführer von Omikron. "Es leuchtet ein, dass mit einer größeren Datenmenge die statistische Signifikanz steigt und man sich also auf die BI-Analyseergebnisse besser verlassen kann", betont er und erläutert: "Sind aber schon die Ausgangsdaten unrichtig, doppelt oder inkonsistent, wird diese Signifikanz trügerisch: Im schlimmsten Fall hat man dann zwar mathematisch folgerichtige und scheinbar klare Ergebnisse - die aber faktisch falsch sind. Wenn dann aus den Analyse-Ergebnissen auch noch Handlungen abgeleitet werden - was ja das Ziel von BI ist -, sind negative Folgen vorprogrammiert." Dieser Aspekt werde in der aktuellen Diskussion zu Big Data jedoch noch weitgehend ausgeklammert.