Die Experten der Online Solutions Group (OSG), einer Münchner Online-Marketing-Agentur, stoßen bei ihrer täglichen Analyse von Webseiten oft auf die gleichen, wiederkehrenden Fehler. Der folgende Ratgeber zeigt die fünf häufigsten SEO-Fallstricke für Unternehmen – und gibt gleichzeitig Hilfestellung, wie sich diese vermeiden lassen.

Weitere Informationen: www.onlinesolutionsgroup.de

1.) Fehlende Keyword-Strategie

Eine durchdachte Keyword-Strategie bildet die Basis aller SEO-Aktivitäten. Mittels Keyword-Analysen betreibt man aktiv Marktforschung und findet potenziell relevante Suchbegriffe für den eigenen Webauftritt. Dabei geht es unter anderem um die Frage, ob die Zielgruppe beispielsweise häufiger nach „Spielwaren“ oder „Spielzeug“ sucht. Doch diese Analyse wird von Websitebetreibern häufig nicht durchgeführt. Und wenn sie durchgeführt wird, dann zumeist nur mit aufgesetzter Unternehmensbrille.

Nutzer geben in den Suchschlitz bei Google Suchphrasen ein, hinter denen eine bestimmte Intention (z. B. Informations- oder Kaufabsicht) steht. Verwendet man die „richtigen“ Keywords in seinen Texten, Überschriften und in der Navigation, dann wird die Auffindbarkeit des eigenen Contents von der relevanten Zielgruppe im Netz erheblich erleichtert. Geeignete Schlüsselwörter versprechen qualifizierten Traffic auf der Webseite und damit in der Folge mehr Konversionen und mehr Umsatz. Ohne eine gute Keyword-Strategie kommen keine oder die falschen Besucher auf die Website.

Eine valide Keyword-Strategie sollte aus Schlüsselwörtern oder Schlüsselwörtergruppen bestehen, die die reale Nachfrage der Konsumenten repräsentieren und letztlich bestimmten Landingpages zugeordnet werden.

2.) Schlecht strukturierter Content

Ein Fehler, der sich leider bei vielen Webseiten beobachten lässt: Die (Text)-Inhalte an sich sind fachlich einwandfrei, allerdings bietet die Seite optisch keinerlei Anreiz, sich mit ihr näher auseinanderzusetzen. Content ist jedoch kein Selbstzweck – er muss im Sinne besserer Lesbarkeit so aufbereitet sein, dass er auch von eiligen Lesern leicht erfasst werden kann, indem visuelle Ankerpunkte geboten werden. Das hilft nicht zuletzt Suchmaschinen bei der thematischen Einordnung einer Seite.

Websitebetreiber sollten in ihren Texten daher Fettungen für zentrale Keywords und wichtige Aussagen, Zwischenüberschriften zur Strukturierung sowie multimedialen Content wie Bilder oder Videos zur Auflockerung nutzen. So können auch Schnell-Leser, so genannte Skimmer, die einen Text nur überfliegen, einfach die wichtigsten Informationen aus ihm ziehen.

Denn ein perfekt optimierter Text, der aber dem Nutzer keinen Lesespaß bringt, wird auch in der Bewertung durch Google nicht besonders gut abschneiden.

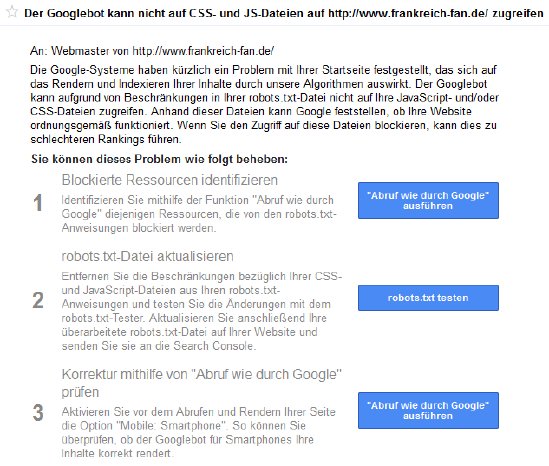

3.) Blockierte CSS- oder JavaScript-Dateien

Google hat vor einiger Zeit eine Änderung an den Webmaster Guidelines vorgenommen. Seitdem verlangt die Suchmaschine, dass CSS- und JavaScript-Dateien vor dem Zugriff des Crawlers nicht mehr gesperrt werden. Ansonsten sind schlechtere (mobile) Rankings zu befürchten.

Je mehr Informationen man Google & Co. bereitstellt, desto besser versteht die Suchmaschine den Aufbau einer Website und kann die richtigen Inhalte crawlen und indexieren. Und außerdem zeigen Webmaster Google auf diese Weise auch, dass man nichts zu verbergen hat. Denn so mancher Webmaster nutzte in der Vergangenheit Stylesheet- bzw. JavaScript-Dateien, um Google auf diese Weise Text vorzugaukeln, den Besucher der Seite nie zu Gesicht bekamen.

Websitebetreiber sollten den aktuellen Webmaster Guidelines daher unbedingt folgen, um keine Abwertung ihrer Seite zu riskieren.

4.) Duplicate Content

Es gibt kaum eine Website, die keine doppelten Inhalte aufweist – teils ist dies den Websitebetreibern bewusst, teils aber nicht. Von externem Duplicate Content spricht man, wenn man die gleichen Inhalte mit anderen Webseiten teilt. Interner Duplicate Content hingegen hängt häufig mit einer fehlerhaften Konfiguration des Webservers zusammen. Dies hat zur Folge, dass die gleichen Inhalte unter verschiedenen Website-Adressen (URLs) aufrufbar sind. Zwar bestrafen die Suchmaschinen Webseiten mit Duplicate Content nicht direkt, allerdings wird eine Seite vom Bot der Suchmaschine weniger effizient gecrawlt. So kann es passieren, dass wichtige, aktuelle Inhalte der Website gar nicht oder erst mit deutlicher Verzögerung im Netz auffindbar sind.

Zur Lösung des Duplicate-Content-Problems haben Websitebetreiber verschiedene Möglichkeiten. So können beispielsweise kanonische URLs zum Einsatz kommen oder man richtet so genannte 301-Redirects von den Seiten mit Duplicate Content zu den Ursprungsseiten ein, falls Inhalte wiederverwendet werden.

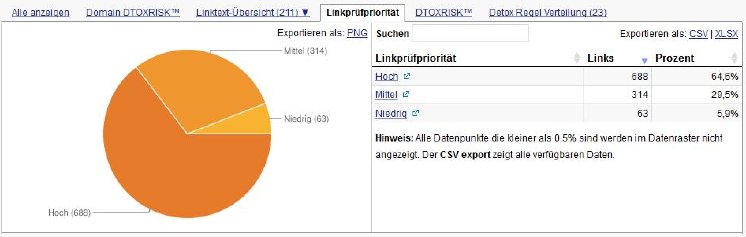

5.) Schlechtes Backlinkprofil

Auch wenn der Content im Vordergrund steht: Will man Seiten mit starker Konkurrenz zum Ranken bringen, so sind qualitativ gute Links im SEO nach wie vor wichtig. Doch natürliches Linkbuilding ist mittlerweile zu einer hochkomplexen Angelegenheit geworden, die nur von seriösen Anbietern durchgeführt werden sollte. Denn nichts schadet den eigenen Rankings mehr als ein schlechtes Backlinkprofil. Unseriöse Backlinks stellen ein hohes Risiko für jeden Websitebetreiber dar. Google bestraft seit dem so genannten Penguin-Update 2012 gnadenlos Webseiten, die billige und schnelle Backlink-Taktiken praktizieren, was im schlimmsten Fall das Ende des eigenen Online-Businesses bedeuten kann. Dennoch vertrauen nach wie vor Unternehmen unseriösen Agenturen. Wenn Websitebetreiber wissen oder vermuten, dass in der Vergangenheit in Sachen Backlinks gegen die Google-Richtlinien verstoßen wurde, sollte das Backlinkprofil am besten durch eine erfahrene Agentur geprüft werden. Diese kann die Backlink-Struktur analysieren und eventuelle Altlasten beseitigen.

Kümmen sich Unternehmen selbst um ihr Linkbuilding, dann ist dabei unbedingt auf einen natürlichen Mix aus verschiedenen themenrelevanten Quellen wie soziale Netzwerke, Foren, Blogs usw. zu achten.